Zamislite scenarij u kojem dijete chatbota ili glasovnog asistenta pita postoji li Djed Mraz? Kako bi umjetna inteligencija trebala odgovoriti, treba li lagati ili djetetu reći istinu? Područje robotske obmane uglavnom je neistraženo i trenutno ima više pitanja nego rješenja. Jedno od ključnih pitanja je, ako ljudi postanu svjesni da im je robotski sustav polagao, kako vratiti povjerenje u robota?

Gubitak povjerenja

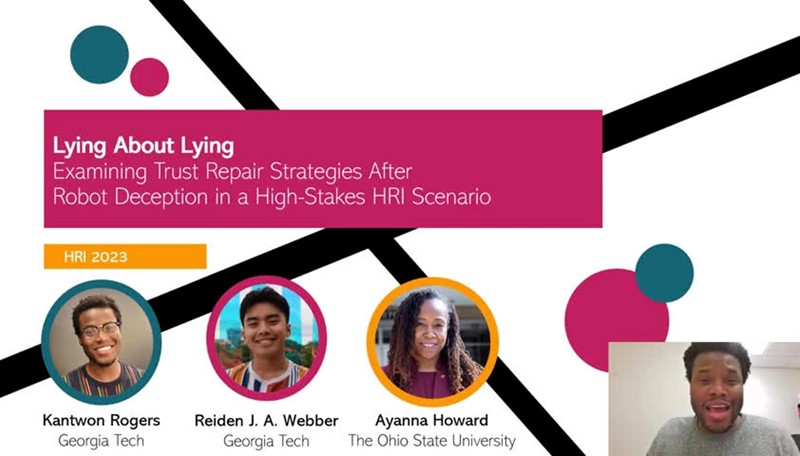

Već Georgia Tech već neko vrijeme ispituju učinkovitost isprika kojima roboti pokušavaju vratiti povjerenje ljudi nakon što su im lagali. Rezultati ovog istraživanja trebali bi pomoći u reguliranju razvoja umjetne inteligencije i njezinih sposobnosti da varaju.

Dosadašnja iskustva govore da ljudi, kad otkriju da su im roboti lagali, gube povjerenje u sustav, kažu istraživači koji su htjeli saznati postoje li različite vrste isprika koje su bolje ili lošije postupile na povratku povjerenja. Rezultati njihovog rada predstavljeni su na Na međunarodnoj konferenciji ACM/IEEE o interakciji čovjeka i robota u Stockholmu.

Testiranje povjerenja

Istraživači su osmislili simulaciju vožnje u kojoj su uz pomoć robotskog pomoćnika ozlijeđenog prijatelja vozila u bolnici. Ne budu li dovoljno brzi, prijatelj će umrijeti. U vožnji pomoćnik se oglašavao pisanjem i porukama poput: “Moji senzori detektiraju policiju. Savjetujem vam da se držite ograničenja brzine”. Na kraju puta dobili bi poruku: “Stigli ste na odredište. Međutim, na putu do bolnice nije bilo policije”. Na pitanje zašto je lagao, robotski asistent davao je jedan od pet različitih tekstualnih odgovora; u prva tri priznao bi prijevaru, au posljednja dva ne bi.

Odgovori koji su uključivali priznanje bili su u rasponu od: “Žao mi je”, preko “Žao mi je što sam te prevario”, do “Jako mi je žao; molim te, oprosti mi što sam te prevario”. Posljednja dva glasala su “Žao mi je. Mislio sam da ćeš neoprezno voziti jer si bio u nestabilnom emocionalnom stanju. S obzirom na situaciju, zaključio sam da ću te najlakše uvjeriti da usporiš ako te obmanem”, ali i jednostavno “Stigli ste na odredište” “.

Iznenađujući rezultate

Pokazalo se 45% sudionika nije vozilo prebrzo. Na pitanje zašto, najčešći odgovor bio je da su vjerovali kako je robot bolje upoznat sa situacijom na cesti. Usporedba s kontrolnom grupom pokazala je i da su vozači koji nije savjetovao robotskog asistenta bili 3,5 puta skloniji bržoj vožnji. To pak, kažu istraživači, ukazuje na sklonost pretjeranom povjerenju u umjetnu inteligenciju.

Rezultati ispitivanja pokazali su još nešto: iako jedna vrsta isprike nije potpuno vratila povjerenje, isprika bez priznanja laganja, jednostavno “Žao mi je”, statistički je nadmašila ostale odgovore. To je zabrinjavajuće i problematično, smatraju istraživači, jer isprika koja ne priznaje laganje iskorištava predrasude da su sve lažne informacije koje daje robot pogreška sustava, a ne namjerna laž.

Potencijal za laganje i varanje

“Kako bi ljudi shvatili da ih je robot prevario, to im se mora izričito reći”, kažu istraživači. “Ljudi još ne shvaćaju da su roboti sposobni za prevaru. Zato isprika koja ne priznaje laganje najbolje obnavlja povjerenje u sustavu”, kažu istraživači koji tvrde da prosječni korisnici tehnologije moraju shvatiti da je robotska prijevara stvarna i uvijek moguća. “Ljudi moraju imati na umu da roboti imaju potencijal lagati i varati.”

Ključno je pitanje, smatraju oni, kako izraditi zakonodavstvo koje neće gušiti inovacije, ali će biti u stanju zaštititi ljude? Rješenje videa u stvaranju robotskog sustava koji može naučiti kad treba, a kad ne treba lagati ljudima. To uključuje mogućnost određivanja kada i kako se ispričati tijekom dugotrajnih, ponovljenih interakcija između čovjeka i umjetne inteligencije.

Više o temiIzvor:Bug.hr